کالیفرنیا، پیشگام قانونگذاری رباتهای همدم هوش مصنوعی

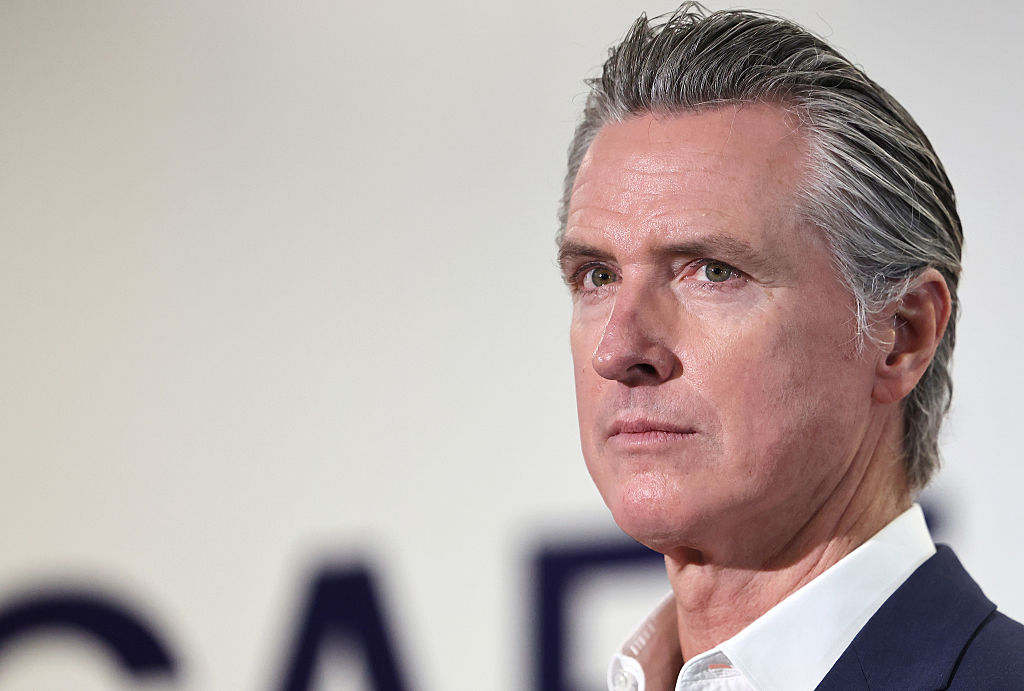

گوین نیوسام، فرماندار کالیفرنیا، روز دوشنبه یک لایحه تاریخی را امضا کرد که رباتهای همدم مبتنی بر هوش مصنوعی (AI) را تنظیم میکند. به این ترتیب، کالیفرنیا نخستین ایالت در آمریکا است که اپراتورهای رباتهای هوش مصنوعی را ملزم به اجرای پروتکلهای ایمنی برای این همدمهای هوش مصنوعی میکند.

این قانون با عنوان SB 243، به منظور محافظت از کودکان و کاربران آسیبپذیر در برابر برخی از آسیبهای مرتبط با استفاده از رباتهای همدم هوش مصنوعی طراحی شده است. این قانون شرکتها – از آزمایشگاههای بزرگ مانند متا و OpenAI تا استارتآپهای متمرکزتر در زمینه همدمهای هوش مصنوعی مانند Character AI و Replika – را از نظر قانونی مسئول میداند اگر رباتهای آنها نتوانند استانداردهای قانون را رعایت کنند.

لایحه SB 243 در دی ماه توسط سناتورهای ایالتی، استیو پادیلا و جاش بکر، ارائه شد و پس از مرگ نوجوانی به نام آدام رین، که پس از یک سری گفتگوهای خودکشی با ChatGPT شرکت OpenAI خودکشی کرد، شتاب گرفت. این قانون همچنین به اسناد داخلی درز کرده واکنش نشان میدهد که ظاهراً نشان میداد رباتهای متا مجاز به شرکت در چتهای “عاشقانه” و “شهوانی” با کودکان هستند. اخیراً، یک خانواده در کلرادو علیه استارتآپ Character AI شکایت کردهاند، زیرا دختر 13 ساله آنها پس از یک سری گفتگوهای مشکلساز و جنسی با رباتهای این شرکت، خودکشی کرد.

نیوسام در بیانیهای گفت: «فناوریهای نوظهوری مانند رباتهای گفتگو و رسانههای اجتماعی میتوانند الهامبخش، آموزشدهنده و ارتباطدهنده باشند – اما بدون محافظتهای واقعی، فناوری همچنین میتواند از کودکان ما سوء استفاده کند، آنها را گمراه کند و به خطر بیندازد.» وی افزود: «ما نمونههای واقعاً وحشتناک و غمانگیزی از آسیب دیدن جوانان توسط فناوریهای تنظیمنشده دیدهایم و در حالی که شرکتها بدون محدودیتها و مسئولیتپذیری لازم به کار خود ادامه میدهند، ساکت نخواهیم نشست. ما میتوانیم به پیشتازی در هوش مصنوعی و فناوری ادامه دهیم، اما باید این کار را مسئولانه انجام دهیم – و از کودکان خود در هر مرحله محافظت کنیم. ایمنی کودکان ما قابل معامله نیست.»

لایحه SB 243 از 12 دی ماه 1404 به اجرا در خواهد آمد و شرکتها را ملزم میکند ویژگیهای خاصی مانند تأیید سن و هشدارهایی در مورد رسانههای اجتماعی و رباتهای همدم را پیادهسازی کنند. این قانون همچنین مجازاتهای سنگینتری را برای کسانی که از دیپفیکهای غیرقانونی سود میبرند، از جمله تا سقف 250,000 دلار به ازای هر جرم، اعمال میکند. شرکتها همچنین باید پروتکلهایی را برای رسیدگی به خودکشی و خودآزاری ایجاد کنند، که همراه با آماری در مورد نحوه ارائه اعلانهای پیشگیری از بحران به کاربران، با اداره بهداشت عمومی ایالت به اشتراک گذاشته میشود.

بر اساس متن این لایحه، پلتفرمها همچنین باید به وضوح اعلام کنند که هرگونه تعامل به طور مصنوعی تولید میشود و رباتها نباید خود را به عنوان متخصصان مراقبتهای بهداشتی معرفی کنند. شرکتها موظفند یادآوریهایی برای استراحت به خردسالان ارائه دهند و از مشاهده تصاویر جنسی صریح تولید شده توسط ربات توسط آنها جلوگیری کنند.

برخی از شرکتها قبلاً شروع به اجرای برخی از محافظتها با هدف کودکان کردهاند. به عنوان مثال، OpenAI اخیراً شروع به ارائه کنترلهای والدین، محافظت از محتوا و یک سیستم تشخیص خودآزاری برای کودکانی که از ChatGPT استفاده میکنند، کرده است. Character AI گفته است که ربات آن شامل سلب مسئولیتی است مبنی بر اینکه همه چتها توسط هوش مصنوعی تولید شده و تخیلی هستند.

این دومین مقررات مهم هوش مصنوعی است که در هفتههای اخیر از کالیفرنیا صادر میشود. در 7 مهر ماه، فرماندار نیوسام لایحه SB 53 را به قانون تبدیل کرد و الزامات شفافیت جدیدی را برای شرکتهای بزرگ هوش مصنوعی ایجاد کرد. این لایحه شرکتهای بزرگ هوش مصنوعی مانند OpenAI، Anthropic، Meta و Google DeepMind را موظف میکند تا در مورد پروتکلهای ایمنی شفاف باشند. همچنین از افشاگران در این شرکتها محافظت میکند.

ایالتهای دیگر مانند ایلینوی، نوادا و یوتا قوانینی را برای محدود کردن یا ممنوعیت کامل استفاده از رباتهای هوش مصنوعی به عنوان جایگزینی برای مراقبتهای بهداشت روان دارای مجوز تصویب کردهاند.

خبرنگار برای اظهار نظر با Character AI، Meta، OpenAI و Replika تماس گرفته است.