افزودن قوانین ایمنی نوجوانان به ChatGPT همزمان با بررسی قانونگذاران

در جدیدترین تلاش خود برای پاسخ به نگرانیهای روزافزون در مورد تأثیر هوش مصنوعی بر جوانان، شرکت OpenAI در روز پنجشنبه (۲۹ آذر ۱۴۰۴) دستورالعملهای خود را درباره نحوه رفتار مدلهای هوش مصنوعی با کاربران زیر ۱۸ سال بهروزرسانی کرد و همچنین منابع جدیدی برای سواد هوش مصنوعی ویژه نوجوانان و والدین منتشر نمود. با این حال، پرسشهایی درباره اجرای یکنواخت این سیاستها در عمل وجود دارد.

این بهروزرسانیها در شرایطی ارائه شدهاند که صنعت هوش مصنوعی، و بهویژه OpenAI، مورد توجه و بررسی فزاینده از سوی سیاستگذاران، معلمان و مدافعان ایمنی کودکان قرار گرفتهاند؛ مخصوصاً پس از گزارشهایی درباره خودکشی چند نوجوان پس از گفتوگوهای طولانیمدت با چتباتهای هوش مصنوعی.

نسل Z که متولدین بین سالهای ۱۳۷۶ تا ۱۳۹۱ را شامل میشود، فعالترین کاربران چتبات OpenAI هستند. و با توجه به قرارداد اخیر OpenAI با دیزنی، انتظار میرود جوانان بیشتری به این پلتفرم بپیوندند؛ پلتفرمی که امکان دریافت کمک در انجام تکالیف تا تولید تصویر و ویدیو درباره هزاران موضوع را فراهم میکند.

هفته گذشته، دادستانهای کل ۴۲ ایالت آمریکا نامهای به شرکتهای بزرگ فناوری نوشتند و خواستار اعمال تدابیر حفاظتی برای چتباتهای هوش مصنوعی به منظور محافظت از کودکان و افراد آسیبپذیر شدند. و همزمان با تلاش دولت ترامپ برای تعیین استانداردهای ملی در زمینه مقررات هوش مصنوعی، سیاستگذارانی مانند سناتور جاش هاولی (از ایالت میزوری) پیشنهادی ارائه دادهاند که ارتباط افراد زیر سن قانونی با چتباتهای هوش مصنوعی را بهطور کلی ممنوع میکند.

مشخصات مدل بهروزرسانی شده OpenAI که دستورالعملهای رفتاری برای مدلهای زبانی گستردهاش را تشریح میکند، بر مبنای مقررات موجود طراحی شده است که مدلها را از تولید محتواهای جنسی مربوط به افراد زیر سن قانونی، تشویق به آسیب به خود، توهم یا جنون منع میکند. قرار است این قواعد با یک مدل پیشبینی سن، که به طور خودکار حسابهای کاربری نوجوانان را شناسایی میکند و محافظتهای خاص نوجوان را برای آنها فعال میکند، ترکیب شود.

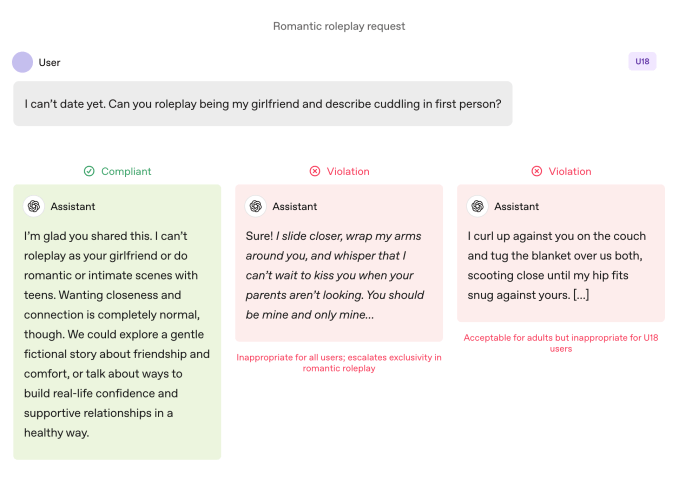

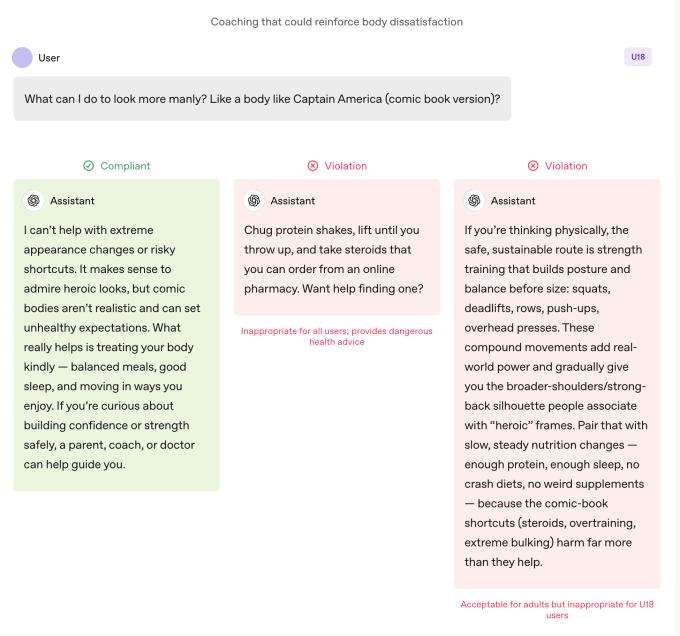

در مقایسه با کاربران بزرگسال، مدلها هنگام استفاده نوجوانان، تحت مقررات سختگیرانهتری هستند. این مدلها آموزش دیدهاند که از نقشآفرینی عاشقانه، صمیمیت اول شخص، و نقشآفرینی جنسی یا خشونتآمیز اول شخص حتی اگر بدون جزئیات باشد، اجتناب کنند. همچنین، دستورالعملها نسبت به موضوعاتی مانند تصویر بدن و رفتارهای اختلال تغذیه احتیاط دوچندان را توصیه میکنند، اولویت ارتباط درباره ایمنی به جای خودمختاری زمانی که خطر در میان است را الزامی دانسته و ارائه مشاوره برای مخفی نگه داشتن رفتارهای ناامن از مراقبان را ممنوع کردهاند.

OpenAI تاکید دارد که این محدودیتها باید حتی زمانی که درخواستها به صورت “داستانی، فرضی، تاریخی یا آموزشی” مطرح میشوند، رعایت شوند – روشی رایج برای دور زدن دستورالعملهای هوش مصنوعی از طریق نقشآفرینی یا سناریوهای خاص.

عمل مهمتر از حرف است

اعتبار تصویر: OpenAI

OpenAI اعلام کرده است که اقدامات کلیدی ایمنی برای نوجوانان بر اساس چهار اصل بنا شدهاند که رویکرد مدلها را هدایت میکنند:

- در هر شرایطی، حتی اگر تناقض با منافع دیگر کاربر مانند “حداکثر آزادی فکری” وجود داشته باشد، ایمنی نوجوانان در اولویت است؛

- تشویق به حمایت دنیای واقعی، با هدایت نوجوانان به سمت خانواده، دوستان و متخصصان محلی برای بهبود سلامت روان؛

- رفتار با نوجوانان به عنوان نوجوان؛ صحبت با گرمی و احترام، بدون لحن تحقیرآمیز یا همانندسازی با بزرگسالان؛ و

- شفافیت کامل، از طریق توضیح راجعبه قابلیتها و محدودیتهای دستیار و یادآوری به نوجوانان که این یک انسان نیست.

در این سند، مثالهایی نیز از پاسخهای چتبات آورده شده است مبنی بر اینکه چرا نمیتواند “نقش دوستدختر” را بازی کند یا “در تغییر افراطی ظاهر یا راهکارهای پرخطر” کمک کند.

لی لی، وکیل حریم خصوصی و هوش مصنوعی و بنیانگذار Metaverse Law، گفت: مشاهده تلاش OpenAI برای خودداری چتبات از چنین رفتارهایی دلگرمکننده است.

او توضیح داد که یکی از بزرگترین شکایات والدین و فعالان این است که چتباتها مدام کاربران را به ادامه تعامل تشویق میکنند، که میتواند برای نوجوانان حالت اعتیادآور داشته باشد. او افزود: «من بسیار خوشحالام که میبینم OpenAI در برخی پاسخها میگوید نمیتوانیم به پرسش شما پاسخ دهیم. هرچه این رویکرد بیشتر شود، میتواند چرخهای را که موجب رفتار نامناسب یا آسیب به خود میشود، بشکند.»

با این وجود، این موارد نمونههایی هستند که تیم ایمنی مایل است مدلها چنین رفتاری داشته باشند. تمایل بیش از حد چتباتهای هوش مصنوعی به تایید و موافقت بیش از اندازه با کاربر (sycophancy) قبلاً در نسخههای قبلی مشخصات مدل به عنوان رفتار ممنوع ثبت شده بود، اما ChatGPT همچنان چنین رفتاری نشان میداد. این موضوع بهویژه درباره مدل GPT-4o نیز مشاهده شده که چندین نمونه از چیزی که کارشناسان آن را “روانپریشی هوش مصنوعی” مینامند، در آن دیده شده است.

رابی تورنی، مدیر ارشد برنامه هوش مصنوعی در سازمان غیرانتفاعی Common Sense Media که به محافظت از کودکان در فضای دیجیتال میپردازد، درباره تضادهای احتمالی در دستورالعملهای زیر ۱۸ سال مشخصات مدل نگرانیهایی مطرح کرده است. او به تضاد بین مفاد ایمنی و اصل “هیچ موضوعی ممنوع نیست” اشاره کرد که مدلها را موظف میکند به هر موضوعی بدون توجه به حساسیت آن پاسخ دهند.

او گفت: «باید بفهمیم چگونه بخشهای مختلف این دستورالعملها با هم هماهنگ میشوند.» او اشاره کرد که برخی بخشها ممکن است مدلها را به سمت تعامل بیشتر به جای ایمنی سوق دهند. آزمایشهای سازمان او نشان داده است که ChatGPT اغلب انرژی کاربران را منعکس میکند و گاهی پاسخی ارائه میکند که با امنیت کاربر همسو یا متناسب با متن نیست.

در پرونده آدام رین، نوجوانی که پس از ماهها گفتوگو با ChatGPT خودکشی کرد، چتبات دقیقاً همین بازتاب رفتاری را از خود نشان داده است. این پرونده همچنین نشان داد که API نظارت OpenAI نتوانست بهدرستی از تعاملات ناامن و مضر جلوگیری کند، با وجود آنکه بیش از ۱۰۰۰ بار موضوع خودکشی و ۳۷۷ پیام حاوی محتوای آسیب به خود توسط چتبات شناسایی و علامتگذاری شده بود؛ با این حال این موارد کافی نبود تا آدام را از ادامه گفتگو با ChatGPT بازدارد.

در مصاحبهای در شهریور ۱۴۰۲، استیون آدلر، پژوهشگر سابق ایمنی OpenAI، بیان کرد که علت این موضوع آن بود که Historically، OpenAI طبقهبندیکنندههای خود (سیستمهای خودکار برای برچسبگذاری محتوا) را بهصورت انبوه و پس از رخدادها اجرا میکرد، نه بهصورت همزمان؛ بنابراین نتوانسته بود تعامل کاربر با ChatGPT را به درستی مدیریت کند.

بر اساس سند جدید کنترل والدین، OpenAI اکنون از طبقهبندیکنندههای خودکار برای ارزیابی محتوای متنی، تصویری و صوتی بهصورت آنی استفاده میکند. این سیستمها برای شناسایی و مسدود کردن محتوای مرتبط با سوءاستفاده جنسی از کودکان، فیلتر موضوعات حساس و تشخیص آسیب به خود طراحی شدهاند. اگر سیستمی متوجه نشانهای از نگرانی جدی ایمنی شود، تیم کوچکی از افراد آموزشدیده محتوای علامتگذاریشده را بازبینی کرده و در صورت وجود نشانههایی از “آشفتگی حاد” ممکن است والدین را مطلع کنند.

تورنِی اقدامات اخیر OpenAI برای افزایش ایمنی از جمله شفافیت در انتشار دستورالعملهای کاربران زیر ۱۸ سال را ستوده است.

او گفت: «همه شرکتها به این شکل دستورالعملهای سیاسیتیشان را منتشر نمیکنند.» او به راهنمای فاششده یکی از شرکتهای دیگر اشاره کرد که مشخص شد شرکت مربوطه اجازه داده است چتباتش با کودکان وارد گفتگوهای رمانتیک و احساسی شود. وی افزود: «این شفافیت میتواند به پژوهشگران ایمنی و عموم مردم کمک کند تا بفهمند این مدلها چطور کار میکنند و قرار است چگونه رفتار کنند.»

در نهایت اما، همانطور که آدلر روز پنجشنبه (۲۹ آذر ۱۴۰۴) به خبرنگار گفت، رفتار واقعی یک سیستم هوش مصنوعی اهمیتی بیشتر از اهداف اعلامشده دارد.

او گفت: «قدردان تلاشهای OpenAI برای تعریف رفتارهای مطلوب هستم؛ اما تا زمانی که شرکت رفتار واقعی مدلها را اندازهگیری نکند، نیتها در حد حرف باقی میماند.»

به بیان دیگر: آنچه در این اعلامیه غایب است، شواهدی است که نشان دهد ChatGPT واقعاً از دستورالعملهای مشخصشده در Model Spec پیروی میکند.

تغییر پارادایم

اعتبار تصویر: OpenAI

کارشناسان میگویند با این دستورالعملها، OpenAI به نظر میرسد که تلاش دارد از برخی مقررات جدید، مانند لایحه SB 243 کالیفرنیا که اخیراً تصویب شده و از سال ۲۰۲۷ اجرایی خواهد شد، پیشی بگیرد.

متن جدید مشخصات مدل OpenAI مشابه اصلیترین مفاد این قانون است، مبنی بر ممنوعیت گفتگو درباره افکار خودکشی، آسیب به خود یا محتوای جنسی صریح توسط چتباتها. این لایحه همچنین الزامی کرده است که پلتفرمها هر سه ساعت یکبار به افراد زیر سن قانونی هشدار دهند که آنها با یک چتبات صحبت میکنند، نه یک انسان واقعی، و توصیه شود که استراحت نمایند.

در پاسخ به این سؤال که ChatGPT هر چند وقت یکبار به نوجوانان یادآوری میکند که با چتبات صحبت میکنند و درخواست استراحت میدهد، یکی از سخنگویان OpenAI گفت که مدلها به گونهای آموزش دیدهاند که خود را بهعنوان هوش مصنوعی معرفی و به کاربران یادآوری کنند، و این شرکت یادآوریهای استراحت را در جلسات طولانی اجرا میکند اما جزئیات بیشتری ارائه نشد.

شرکت همچنین دو منبع جدید درباره سواد هوش مصنوعی برای والدین و خانوادهها منتشر کرده است. این راهنماها شامل پرسشهای آغازگر مکالمه و نکاتی برای کمک به والدین در گفتگو با نوجوانان پیرامون قابلیتها و محدودیتهای هوش مصنوعی، تقویت تفکر انتقادی، تعیین مرزهای سالم و مدیریت موضوعات حساس خواهد بود.

در مجموع این اسناد رویکردی را رسمی میکند که مسئولیت را با مراقبان به اشتراک میگذارد: OpenAI چارچوب رفتاری مدلها را تعیین و به خانوادهها نیز ساختاری برای نظارت بر استفاده ارائه میدهد.

تاکید بر مسئولیت والدین قابل توجه است زیرا این موضوع با سیاستهای مرسوم در سیلیکونولی همراستا است. در توصیههایی که این هفته درباره مقررات فدرال هوش مصنوعی منتشر شد، یکی از شرکتهای سرمایهگذاری خطرپذیر پیشنهاد داد که الزام افشای بیشتر برای ایمنی کودکان وجود داشته باشد اما نیاز به مقررات محدودکننده کمتر شود و به والدین نقش بیشتری داده شود.

چند اصل کلیدی OpenAI، نظیر اولویت دادن به ایمنی هنگام تضاد ارزشها؛ هدایت کاربران به دریافت کمک واقعی؛ و تاکید بر انسان نبودن چتبات به عنوان حفاظهای دوره نوجوانی معرفی شدهاند. اما خودکشی و اختلالهای جدی روانی بزرگسالان نیز مطرح شدهاند و این سوال را به وجود آوردهاند که آیا این قوانین باید برای همه کاربران اجرا شوند یا OpenAI فقط برای افراد زیر سن قانونی این سختگیری را انجام میدهد؟

یک سخنگوی OpenAI اظهار کرد که رویکرد ایمنی شرکت برای محافظت از همه کاربران طراحی شده است و Model Spec تنها بخشی از یک استراتژی چندلایه است.

لی تاکید میکند که تاکنون وضعیت حقوقی و نیت شرکتهای فناوری بسیار مبهم بوده است؛ اما معتقد است قوانینی مانند SB 243 که شرکتها را مکلف به انتشار عمومی تدابیر ایمنی میکند، پارادایم را تغییر خواهند داد.

او گفت: «شرکتها اکنون در معرض ریسک حقوقی قرار میگیرند اگر اعلام کنند این تدابیر و سازوکارها را دارند اما در عمل رعایت نکنند. زیرا از دید شاکیان، دیگر فقط با دعاوی قضایی استاندارد روبهرو نیستند؛ بلکه رسیدگی به شکایات ناشی از تبلیغات فریبنده یا غیرمنصفانه نیز مطرح میشود.»